生成AIやAIエージェントの急速な普及により、多くの企業が業務効率化や競争力強化を目的としてAI導入を進めています。しかしその一方で、AI開発におけるセキュリティリスクが経営課題として顕在化していることも見逃せません。AIは従来のシステムとは異なり、業務データや顧客情報、社内ノウハウといった高度に機密性の高い情報を直接扱う技術であるため、開発会社のセキュリティ体制次第で企業リスクは大きく変わります。

特に、生成AI、Agentic RAG、AI Workflowを実業務へ組み込む場合、PoC段階では問題が見えにくく、本番運用で初めて情報漏えいやコンプライアンス違反が発覚するケースも少なくありません。その原因の多くは、AIセキュリティを前提としないベンダー選定にあります。

本記事では、「AIセキュリティとは何か」という基本概念から、AI開発においてなぜセキュリティが重要なのか、そして失敗しないAI開発会社の選び方までを体系的に解説します。機能やコストだけでなく、セキュリティを軸にAIベンダーを評価したい企業担当者の方にとって、実践的な判断指針となる内容をお届けします。

AIセキュリティとは?

AIセキュリティとは、企業で利用されるAIシステムを安全かつ信頼できる状態で設計・開発・運用するための総合的な取り組みを指します。具体的には、「AIそのものを守るセキュリティ」と「AI活用によって生じる業務リスクを抑えるセキュリティ」の両面を含む概念です。生成AIやAgentic RAG、AI Workflowが普及する現在、AIセキュリティはAI開発プロジェクトの必須要件となっています。

AIセキュリティの主な保護対象

第一の対象はデータセキュリティです。AI開発では、学習データや企業ドキュメント、ユーザー入力ログなど、機密性の高い情報を扱います。これらのデータが適切に管理されなければ、情報漏洩やプライバシー侵害につながります。そのため、閉域のAWS Private環境での保存、暗号化、アクセス制御、ログ匿名化などがAIセキュリティの中心施策となります。

第二の対象はモデルセキュリティです。Fine-tuningで作成した独自モデルやモデル重み、RAGナレッジベースは企業の重要資産です。開発会社が所有権や管理方法を明確にしない場合、ノウハウ流出や不正利用のリスクが残ります。AIセキュリティでは、モデル保護ポリシー、評価・検証プロセス、セキュアなソースコード実装が求められます。

第三の対象は運用セキュリティです。AI WorkflowやAIエージェントには権限管理と監査証跡が必要です。ERP連携AIやLINE Mini Dapp連携のように実業務へ組み込むほど、ID管理ミスやシャドーAIの発生といった課題が顕在化します。安全設計がないAI開発は、本番運用で事故を起こしやすい点が特徴です。

>>>関連記事:

AI開発におけるセキュリティの重要性

AI開発におけるセキュリティの重要性は、近年かつてないほど高まっています。企業が生成AIやAgentic RAGを活用する場合、業務データ・顧客情報・社内ノウハウなど、極めて機密性の高い情報がAIプロセスへ直接流入します。AI開発会社のセキュリティレベルが不十分であれば、PoC段階では問題がなくても、本番運用で重大な情報漏洩事故を招く可能性があります。

1) AI開発は「データ中心型プロジェクト」である

従来のWebシステム開発と異なり、AI開発はデータそのものが価値の源泉です。学習データやFine-tuning用データセットには、企業の意思決定プロセスや顧客の個人情報が含まれることが多く、開発段階から暗号化・アクセス制御・閉域のAWS Private環境構築が不可欠となります。セキュリティを軽視したAI開発は、競争力を高めるはずのAIをリスク要因へ変えてしまいます。

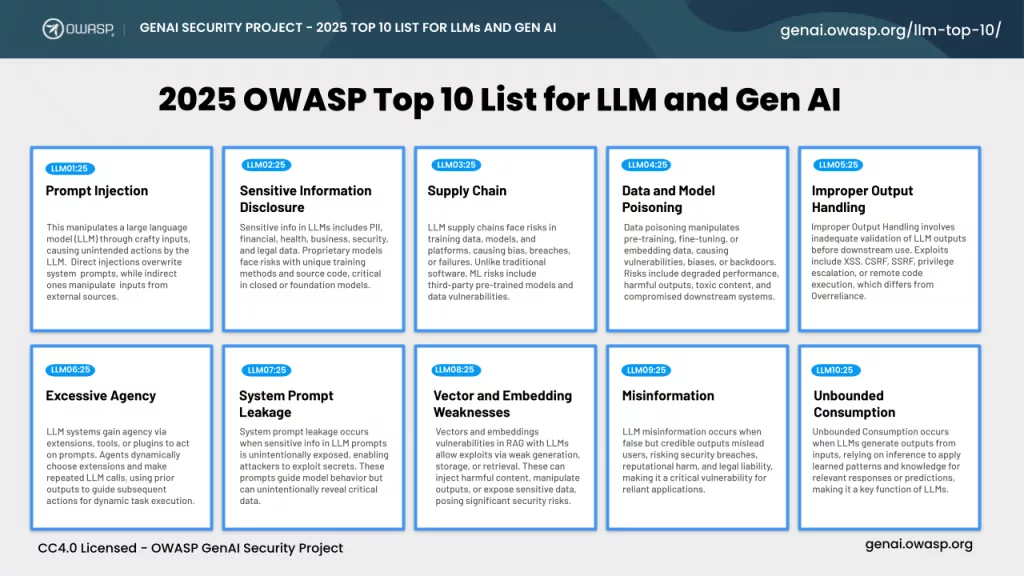

2) AI特有の攻撃が企業損失を拡大させる

出典:OWASP

AIにはPrompt Injection、Jailbreak、モデル汚染といった特有の脅威があります。これらはネットワーク防御だけでは防げず、モデル設計・プロンプト管理・RAGパイプラインの安全設計まで含めた対策が必要です。経験の浅いAI開発会社へ外注すると、出力検証が不足し、不正なAI outputによる契約違反・差別表現・ブランド毀損が発生するケースもあります。

3) 実業務連携でセキュリティ要件はさらに厳しくなる

ERP連携AIなど、AIを基幹業務へ組み込むほどセキュリティの重要性は増します。権限管理ミス、ログの平文保存、ID設計の曖昧さは、運用フェーズで即座に事故へ直結します。信頼できるAI開発会社は、監査証跡の確保や個人情報保護法・GDPRへの対応を前提に、Rust(Axum・Actix)などによる堅牢な実装を提供します。

4) NDAだけでは不十分な理由

多くの企業はNDA締結で安心しがちですが、AI開発ではデータ再利用やモデル所有権の問題が残ります。AI開発委託契約、データ削除ポリシー、第三者モデル利用規定を明確に説明できないベンダーは避けるべきです。セキュリティを体系的に提示できるかどうかが、AI開発会社選びの判断基準となります。

AI開発会社を選ぶ前に確認すべきこと

AIシステムの導入・開発では、機能や精度だけでなく「セキュリティを前提とした開発体制」を持つベンダーを選ぶことが、プロジェクト成功の分岐点となります。契約前には、少なくとも次の観点を体系的に確認する必要があります。

データの取り扱いポリシーと管理方法

AI開発では学習データや業務データに機密情報が含まれることが一般的です。ベンダーがどのようなデータガバナンス方針を持ち、暗号化・アクセス制御・ログ管理を実施しているかを確認しましょう。

- データ保存場所(国内/海外、パブリック・プライベート)

- 個人情報・機密情報のマスキング対応

- 学習後データの削除ルールが明確に定義されていることが重要です。

セキュア開発ライフサイクル(SSDLC)への対応

信頼できるAI開発会社は、要件定義から運用まで一貫したセキュアプロセスを採用しています。脆弱性診断やコードレビュー、モデルのセキュリティ評価を標準工程に組み込んでいるかが判断材料になります。

特に、プロンプトインジェクション対策、APIの認証認可、依存ライブラリ管理など、AI特有のリスクに理解があるかをチェックしましょう。

AIモデルの選定根拠とリスク説明能力

「なぜそのモデルを使うのか」「代替案は何か」を論理的に説明できる企業を選ぶべきです。モデルによってはデータ漏えい、著作権、バイアスなどの課題が異なります。リスクを隠さず提示し、業務要件に合わせて安全設計を提案できるかを確認してください。

クラウド・オンプレ環境のセキュリティ設計

AI基盤をどのインフラで構築するかは、セキュリティとコストに直結します。

- プライベートクラウド構築の経験

- ネットワーク分離、WAF、SIEM連携

- モデル監視(Model Monitoring)

など、運用を見据えた設計実績があるかがポイントです。

実績業界とコンプライアンス対応

金融・製造・医療など規制の強い分野では、法令に沿った開発経験が不可欠です。NDA締結フロー、多言語BrSEによる要件伝達、監査対応ドキュメント作成など、コンプラ面の支援ができる会社かを見極めましょう。

運用フェーズのセキュリティ責任範囲

AIはリリース後も継続改善が必要なシステムです。インシデント発生時の対応、パッチ適用、モデル再学習の手順など、SLAと責任分界が契約前に合意されていることが望ましいです。

このように、AI開発会社の選定では「技術力+AIセキュリティへの理解+説明力」の三位一体が欠かせません。

失敗しないベンダー選定チェックリスト

企業が生成AIやAIエージェントを導入する時代、ベンダー選定の成否がプロジェクト全体のリスクとROIを大きく左右します。

チェックリストの使い方

- 各質問に「はい/いいえ」で回答

- 重要度を【高・中・低】で設定

- 「はい=2点、条件付き=1点、いいえ=0点」でスコア化

- 合計点でベンダーの信頼度を判定

- 80点以上:推奨ベンダー

- 50~79点:要追加確認

- 49点以下:高リスク

A. セキュリティ・ガバナンス体制(必須)

- 情報セキュリティ認証(ISO27001等)を保有していますか

- 閉域のAWS Private環境でAI構築が可能ですか

- ソースコードへのアクセス権限管理ルールは明確ですか

- インシデント発生時の対応フローがありますか

- シャドーAI防止ポリシーを提示できますか

- 外部モデル利用時のデータ分離設計は可能ですか

- 定期的な脆弱性診断を実施しますか

- 出力コンテンツの監査プロセスがありますか

よくある失敗例

- NDAのみで実装・環境ルールがない

- ログが平文保存

- 開発メンバー権限が曖昧

→ これらを事前提示できるかが判断基準です。

B. データ保護・プライバシー

- 個人情報マスキングに対応していますか

- 学習後データの完全削除を保証できますか

- データ保存期間ポリシーはありますか

- 監査ログを顧客へ提供できますか

- 日本リージョン指定保存が可能ですか

- Fine-tuningデータの所有権を明確化できますか

- RAGナレッジベースの暗号化対応

- 入力ログ匿名化

重要ポイント

AI開発はデータ中心型プロジェクトであり、データ保護の説明力=ベンダー力です。

C. AI特有リスク対策

- Prompt Injection対策を実装できますか

- Jailbreak防止フィルター

- 不正output検知

- RAGの安全設計

- モデル汚染防止

- ハルシネーション抑制評価

- 出力差別表現チェック

- モデルモニタリング

D. 契約・コンプライアンス

- AI開発委託契約ひな型がありますか

- モデル知財の扱いを説明

- 再委託ルール

- GDPR対応

- 個人情報保護法対応

- 第三者モデル規定

- 監査条項

- 保守SLA

ベンダーにそのまま聞ける質問テンプレ

- 学習後データはいつ削除されますか

- モデル所有権はどちらに帰属しますか

- Prompt Injection対策の実装方法

- 監査ログの粒度

- AWS Private環境構成図

最終評価ガイド

信頼できるAI開発会社は、認証・環境・AI特有対策・契約を「根拠付きで日本語説」できます。点数だけでなく説明の具体度を重視してください。

まとめ

AIセキュリティを踏まえたAI開発会社の選び方は、企業の競争力とリスク管理を同時に決定づける経営判断です。生成AIやAgentic RAGが業務の中核へ入る現在、AIを「便利なツール」としてだけでなく、データ・モデル・運用プロセスまで含む重要なデジタル資産として捉える必要があります。精度やコストのみでベンダーを選定すると、プロンプトインジェクションや権限管理ミスといったAI特有の脅威が見過ごされ、本番フェーズで情報漏えい・ブランド毀損・コンプライアンス違反につながりかねません。

Relipaは、9年以上の実績を持つAI・Web3・Blockchain開発のテクノロジーパートナーとして、セキュリティを最優先にしたAIシステム設計を提供してきました。

- AI開発会社のセキュリティ評価を相談したい

- 機密データを扱うAgentic RAGの安全設計が必要

- 法令(個人情報保護法・GDPR)を満たす外注スキームを整理したい

そのような課題があれば、Relipaが長年培った経験と日本語BrSE体制を活かし、リスクを可視化した上で最適なアーキテクチャをご提案します。貴社が安心してAIを成長エンジンとして活用できるよう、根拠あるAIセキュリティ実装で伴走いたします。

EN

EN