近年、AIエージェントの活用が急速に進む中で、外部データやシステムと柔軟に連携できる仕組みが求められています。

そこで注目を集めているのが、MCP(Model Context Protocol)サーバーです。

MCPサーバーは、AIエージェントがインターネット上のリソースや独自データベースへアクセスし、より高度な意思決定や自動化を実現するための新しいプロトコルとして注目されています。

本記事では、MCPサーバーの基本概念から仕組み、導入のメリット、実装方法、そして今後の展望までをわかりやすく解説します。

MCPとは?(Model Context Protocolの基本概念)

MCP(Model Context Protocol)とは、AIエージェントが外部のデータソースやアプリケーションと安全かつ柔軟に連携するための新しい通信プロトコルです。

従来のAIモデルは内部情報のみを基に判断していましたが、MCPを利用することで、リアルタイムデータや外部API、データベースなどへアクセスできるようになり、より正確で高度な応答を生成できます。

このプロトコルはAnthropic社 によって2024年に提唱され、2025年現在では Claude、Cursor、Zed などの主要な環境で採用されています。

つまり、MCPは「AIが現実世界とつながるための標準的な橋渡し役」と言えるでしょう。

>>>関連記事:

MCPサーバーとは?

MCPサーバーとは、AIエージェントからの要求を受け取り、外部リソース(データベース・API・ファイルシステムなど)にアクセスして必要な情報を返す役割を持つサーバーです。

つまり、AIエージェントが直接アクセスできない情報を、MCPサーバーが仲介して取得・提供する仕組みになっています。

このサーバーは、Anthropic社 が提唱するModel Context Protocol(MCP)に基づいて動作し、AIモデルと外部データとの間をつなぐ「ゲートウェイ的存在」です。

開発者はMCPサーバーを構築することで、AIが社内データベースや業務アプリケーションなどと安全にやり取りできるようになります。

たとえば、顧客情報を検索する、売上データを取得する、最新の天気情報を呼び出すといった処理も、MCPサーバー経由で自動化が可能になります。

MCPサーバーの仕組み

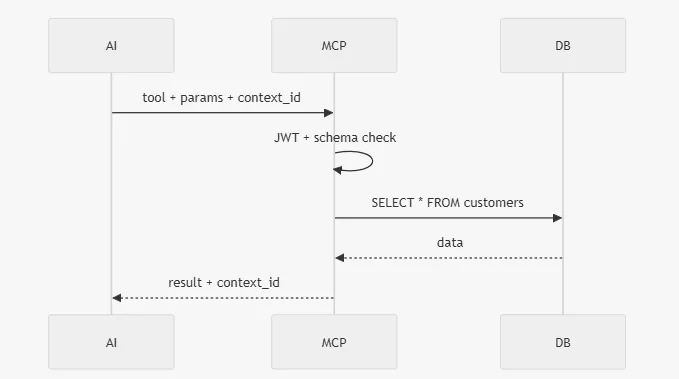

MCP(Model Context Protocol)は、AIエージェントと外部データソース(データベース、API、ファイル、他のエージェントなど)を安全で標準化された方法で接続するためのゲートウェイ(中継サーバー)として定義されています。

このプロトコルは特定の通信方式(Transport Layer)やJSON-RPC 2.0に依存するものではなく、JSONベースの独自メッセージフォーマットを採用しています。メッセージはcontext、tool、parameters、result、errorといったスキーマ構造を持ち、厳格なバリデーションルールに基づいて処理されます。

主な特徴

- 通信層(Transport Layer)

STDIO、HTTP+SSE、WebSocketなど、実装に応じて選択可能です。 - メッセージ形式(Message Format)

JSONベースですが、単なるJSON-RPC 2.0ではありません。独自のスキーマと検証ルールを持ち、構造化された情報交換を行います。 - 構成要素(Main Components)

- context:コンテキスト情報

- tool:実行するツールや関数

- parameters:AIが指定するパラメータ

- result / error:処理結果またはエラー情報 - 目的(Purpose)

Claude、Gemini、GPT、Llamaなど、複数のAIモデルに対応するマルチモデル互換性を目指しています。特定のベンダーに依存しないオープンプロトコルです。 - セキュリティ(Security)

トークン認証、JWT、RBAC(ロールベースアクセス制御)およびスキーマ検証を組み合わせることで、アクセス制御とデータ整合性を保証します。

処理の流れ(ワークフロー)

- AIエージェントが必要なデータまたはアクションを判断し、MCP形式のメッセージを生成します。

- MCPサーバーがメッセージを受信し、認証とスキーマ検証を行います。

- MCPサーバーが外部システム(データベース、APIなど)にアクセスしてデータを取得または処理します。

- MCPサーバーが結果(またはエラー)をAIへ返却し、AIがそれを文脈に統合して最終的な応答を生成します。

この流れにより、AIはリアルタイムで安全に外部データを活用できるようになります。

Function Callingとの違い

OpenAIが開発したFunction CallingはOpenAI専用の仕組みですが、MCP(Model Context Protocol)は、複数AIモデル間の連携と標準化を目的としたオープンプロトコルです。

Function Callingが単一の関数呼び出しに特化しているのに対し、MCPは外部データベースやAPI、複数エージェント間の連携を包括的にサポートし、より高いセキュリティとバリデーション機構を備えています。

MCPサーバーは、AIと外部システムをつなぐ安全で標準化された接続基盤です。

この仕組みを導入することで、企業はAIによる自動化、データ連携、マルチモデル運用をより安全かつ効率的に実現できます。

MCPはまさに、「AI時代の共通インターフェース」と言える存在です。

MCPサーバーの実装方法

MCPサーバー構成の基本

MCPサーバーは次の要素で構成されます。

| 要素 | 説明 |

|---|---|

| Transport layer | STDIO / HTTP+SSE / WebSocket に対応(環境に応じて選択可能) |

| Message format | JSONベースだが、JSON-RPCではなく独自のschemaを使用 |

| 主なフィールド | context_id, tool, parameters, auth, result, error |

| Security | JWT・RBAC・schema validation によりアクセス制御 |

| 互換性 | Claude、GPT、Gemini、Llamaなど複数のAIモデルと接続可能 |

実装例(FastMCP + PostgreSQL + JWT)

以下は、MCPサーバーの例です。

この構成はClaudeやGPTなどのAIモデルとそのまま連携可能です。

1. 環境準備

pip install fastmcp psycopg2-binary python-jose[cryptography]

データベース設定(PostgreSQL)

# docker-compose.yml

services:

db:

image: postgres:16

environment:

POSTGRES_DB: mcp_demo

POSTGRES_USER: mcp

POSTGRES_PASSWORD: secret

ports: ["5432:5432"]

docker-compose up -d

データ初期化

CREATE TABLE users (id SERIAL PRIMARY KEY, name TEXT, email TEXT);

INSERT INTO users (name, email) VALUES ('Taro', 'taro@example.com');

MCPサーバーコード(完全準拠)

# mcp_server.py

from fastmcp import MCPServer

import psycopg2

from jose import jwt, JWTError

SECRET_KEY = "your-secret-2025"

ALGORITHM = "HS256"

server = MCPServer(auth="jwt", transport="http", jwt_secret=SECRET_KEY)

@server.tool("get_user_data")

async def get_user_data(user_id: int, context_id: str, auth_token: str):

# JWT検証

try:

payload = jwt.decode(auth_token, SECRET_KEY, algorithms=[ALGORITHM])

except JWTError:

return {"error": "Invalid token"}

# データベース接続

conn = psycopg2.connect(

host="localhost", dbname="mcp_demo", user="mcp", password="secret"

)

cur = conn.cursor()

cur.execute("SELECT name, email FROM users WHERE id = %s", (user_id,))

row = cur.fetchone()

conn.close()

if row:

return {

"context_id": context_id,

"result": {"user_id": user_id, "name": row[0], "email": row[1]},

}

return {"context_id": context_id, "error": "User not found"}

if __name__ == "__main__":

print("MCPサーバーを起動中... http://localhost:8080")

server.run(port=8080)

テストリクエスト

TOKEN=$(python -c "from jose import jwt; print(jwt.encode({'sub': 'test'}, 'your-secret-2025', 'HS256'))")

curl -X POST http://localhost:8080/mcp \

-H "Content-Type: application/json" \

-d '{

"context_id": "ctx_001",

"tool": "get_user_data",

"parameters": {"user_id": 1},

"auth": {"jwt": "'$TOKEN'"}

}'

レスポンス例:

{

"context_id": "ctx_001",

"result": {

"user_id": 1,

"name": "Taro",

"email": "taro@example.com"

}

}

MCPサーバーの実装ポイント

- JSON-RPCは使用しない(MCPは独自スキーマを使用します)

context_idは必須(AIの文脈トラッキングに利用されます)- JWTによる認証でセキュリティを強化

- PostgreSQLなどのスレッドセーフなDBを利用

- FastMCPを用いることでClaudeやGPTとの連携が容易

MCPサーバーは、AIエージェントと外部データソースを接続するための信頼性が高い中間層として機能します。

本実装のように、FastMCP + JWT + PostgreSQLの構成を採用することで、

安全性・拡張性・互換性をすべて満たすプロダクションレベルのAI連携環境を実現できます。

MCPサーバー導入のメリット

MCPサーバーを導入することで、AIエージェントの機能拡張やデータ連携の効率化が大きく向上します。従来のFunction Callingや個別API連携に比べ、MCPは標準化された通信プロトコルを採用しているため、複数のAIモデルや外部システムとの連携をより安全かつ柔軟に行うことができます。

データアクセスの標準化と柔軟性

MCPサーバーは、外部データベースやAPI、ファイル、他のAIエージェントなど、さまざまな情報源へのアクセスを統一フォーマットで実現します。これにより、開発者は各システムごとの接続仕様を意識することなく、効率的にデータ連携を設計できます。

モデル間互換性の確保

MCPは特定のベンダーやモデルに依存しない設計になっており、Claude・GPT・Gemini・Llamaなど異なるAIモデル間でも同一の形式で通信できます。そのため、将来的なモデル変更やマルチモデル運用にもスムーズに対応できます。

セキュリティとアクセス制御の強化

MCPサーバーは、トークン認証やJWT、RBAC(ロールベースアクセス制御)を組み合わせることで、高いセキュリティレベルを実現します。外部システムとの通信やデータ取得も、厳格なバリデーションを通じて安全に行われます。

開発・運用コストの削減

一度MCPサーバーを構築すれば、さまざまなAIエージェントが同じインターフェースを利用して外部データにアクセスできます。これにより、重複開発を削減し、保守性・拡張性の高いシステム運用が可能になります。

>>>関連記事:

ビジネスのスピードと精度の向上

リアルタイムで正確なデータをAIが取得できるため、意思決定のスピードが上がり、より高度な自動化や分析が実現します。MCPサーバーは、データ駆動型のAI活用を推進する基盤となります。

課題と注意点

MCPサーバーはAIエージェントと外部システムを安全かつ柔軟に接続できる強力な仕組みですが、実際の導入・運用にはいくつかの課題と注意点が存在します。本章では、MCP実装時に考慮すべき代表的なポイントを紹介します。

MCP仕様の理解と対応が必要

MCP(Model Context Protocol)は、従来のAPI設計やFunction Callingとは異なる概念を持つ新しいプロトコルです。

そのため、開発チームはMCP/1.0の仕様やメッセージ構造(context_id、tool、parameters、resultなど)を正しく理解し、実装に反映させることが重要です。

セキュリティ設計の複雑化

MCPサーバーは外部データやシステムと通信するため、JWTトークン、認可スキーム、アクセス制御(RBAC)などのセキュリティ対策が必須となります。

特に企業システムと連携する場合は、HTTPS/TLS通信の暗号化や認証ロジックの安全設計が求められます。

運用・保守コストの発生

MCPを本番環境で安定運用するためには、サーバー監視、ログ管理、データベースのメンテナンスなど継続的な運用コストがかかります。

クラウド環境(AWS、GCPなど)を利用することでスケーラビリティを確保できますが、その分初期設計とリソース管理が重要になります。

モデル間の互換性テスト

Claude、GPT、Geminiなど、AIモデルごとにMCPへの対応状況やリクエストフォーマットが微妙に異なる場合があります。

そのため、複数モデル間での互換性テストやバージョン管理を計画的に行うことが推奨されます。

開発初期の学習コスト

MCPはまだ新しい技術であり、公開されているドキュメントや実装例が限られている点も課題です。

開発チームはオープンソースのリポジトリやコミュニティ情報を積極的に活用し、ナレッジを共有していく姿勢が求められます。

MCPサーバーの導入には多くの利点がありますが、同時に上記のような技術的課題や運用上の注意点を理解することが成功の鍵となります。

まとめ

通信の標準化、高いセキュリティ、多様なAIモデルのサポートを実現するMCPは、企業の自動化最適化、運用効率の向上、そして実践的なAI活用の拡大を可能にします。

導入や運用にはいくつかの課題もありますが、技術の急速な進化に伴い、MCPは今後のAIエコシステムにおける重要な標準となるでしょう。今からMCPサーバーの理解と導入を進めることで、企業はAI時代における競争優位を確立できます。

Relipaは、AI・生成AI分野において9年以上の豊富な実績を誇るITソリューションプロバイダーです。多様な業界でのAI導入プロジェクトを成功に導いてきた経験に基づき、高度な技術力と実践的なノウハウを持つエンジニアチームが揃っています。

特に、MCP(Model Context Protocol)をはじめとした最新のAI連携技術に精通しており、クライアントのニーズに合わせた安全かつ効率的なAIシステムの設計・開発をワンストップで提供可能です。

EN

EN