近年、日本国内でも生成AIの活用が着実に広がり、Difyのようにノーコード・ローコードでAIアプリケーションを構築できるプラットフォームは、PoCや業務改善の初期段階において高く評価されています。短期間で試せる手軽さや、専門的な開発スキルを必要としない点は、Difyが多くの企業に選ばれている大きな理由の一つです。

一方で、AI活用が実証段階から実運用・本番利用へと進むにつれて、「データの管理をどこまで自社でコントロールできるのか」「既存の社内システムやセキュリティポリシーとどのように整合させるか」といった、より現実的な検討課題が浮かび上がってきます。これはDifyそのものの問題というよりも、利用フェーズの変化に伴って生じる自然な課題だと言えるでしょう。

こうした背景から近年注目されているのが、DifyをAWS上に構築・運用するという選択肢です。本記事では、Difyの強みを前提としたうえで、どのようなケースでAWS構成が適しているのか、導入判断の考え方、代表的なアーキテクチャ、そして運用コストの観点までを整理し、自社にとって無理のないAI活用の進め方を解説します。

DifyとAWSの概要

Difyとは?

Dify は、生成AIを活用したアプリケーションを、プログラミングなしで開発できるオープンソース基盤です。BaaS と LLMOps を融合したアーキテクチャにより、エンジニアでなくても高度な AI アプリの設計・運用を効率的に行えます。

ChatGPT や Claude、Gemini など複数の大規模言語モデルを組み合わせ、企業ごとの業務プロセスやニーズに応じた独自の AI 活用をスピーディに実現できます。また、オンプレミスやセルフホスティングにも対応しており、Docker や Kubernetes を活用することで、データを社内環境に閉じたまま、安全性を確保した導入が可能です。

>>>関連記事:

AWSとは?

AWS(Amazon Web Services)は、Amazon が提供するクラウドサービスで、サーバーやストレージ、データベース、AI など 200 以上の機能をインターネット経由で利用できます。

自社で設備を管理する必要がなく、仮想リソースを柔軟に増減できるため、効率的かつ安定したシステム運用が可能です。現在は、企業から行政機関まで世界中で利用される、代表的なクラウド基盤となっています。

>>>関連記事:

DifyをAWS上にデプロイするとは?

オープンソースの生成AI開発基盤である Dify を、AWS のクラウドインフラ上に構築・運用することを指します。

AWS の EC2 や ECS、EKS、RDS、S3 などのサービスを活用して Dify をセルフホスティングすることで、生成AIアプリの開発・運用を 自社管理のクラウド環境で行えます。

つまり Dify on AWS とは、「生成AIアプリ開発基盤としての Dify」と「企業向けクラウド基盤である AWS」を組み合わせた、エンタープライズ向けの生成AI運用形態と言えます。

特に Amazon Bedrock と組み合わせることで、生成AIを AWS 内で完結させたエンタープライズ向け構成を実現できます。

どうしてDify AWSを選択すべきか?

LLM 負荷に強いスケーラビリティ

Dify は、LLM 推論やワークフロー実行により、CPU・メモリ・ネットワーク負荷が変動しやすい特性があります。

AWS では、こうした負荷に応じてリソースを柔軟にスケールできるため、Dify のような生成AI基盤と非常に相性が良いと言えます。

他のクラウドでもスケーリングは可能ですが、インスタンスタイプや構成の選択肢が多く、細かな最適化ができる点では AWS が有利です。

Dify の構成に合わせた柔軟なデプロイ方式

AWS では、Dify を以下のように段階的に展開できます。

- PoC:EC2 + Docker Compose

- 本番運用:ECS

- 大規模・複数部門展開:EKS(Kubernetes)

他クラウドでは特定のサービスに構成が寄りやすいケースもありますが、AWS は Dify の成長フェーズに応じて構成を変えやすい点が強みです。

データを閉じたまま AI を活用できるセキュリティ

Dify を業務で利用する場合、社内文書や顧客データなど、機密情報を扱うケースが多くなります。

AWS 上で Dify を運用すれば、データをクラウド外に出すことなく、VPC 内で安全に処理できます。

他のクラウドや SaaS 型 Dify と比べても、アクセス制御・暗号化・監査ログを細かく設計できる点は、AWS 上での Dify 運用の大きな利点です。

既存 AWS 環境とのスムーズな統合

すでに AWS を利用している企業の場合、Dify をそのまま既存環境に組み込めます。

- 社内データベース

- S3 上の業務データ

- 社内 API・業務システム

他クラウド上で Dify を構築する場合、ネットワークや認証連携が複雑になりがちですが、AWS で統一することで Dify を業務自動化の中核として活用しやすくなります。

Dify 運用コストの最適化がしやすい

Dify は利用が広がるにつれて、LLM 利用回数やバックエンド処理が増加します。

AWS では、オートスケーリングや従量課金を活かすことで、Dify の利用状況に応じたコスト設計が可能です。

他クラウドと比較しても、長期運用や大規模展開を前提としたコスト最適化の選択肢が多い点は AWS の強みです。

実績に裏付けられた安心感

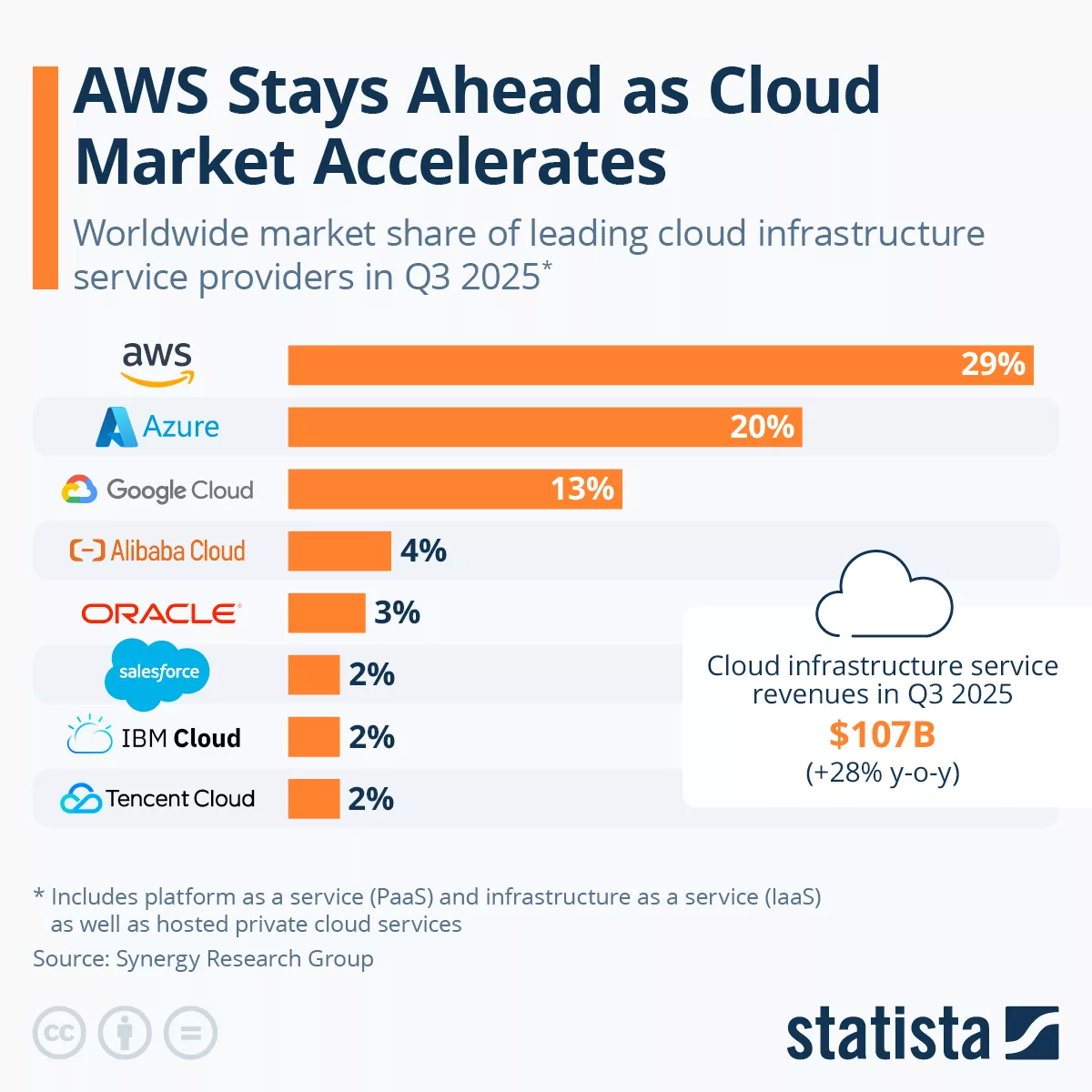

Statista(Synergy Research Group 調査)によると、AWS は世界のクラウドインフラ市場で約 29% のシェアを占めています。

出典:Statista

Dify のような生成AI基盤を安定して運用するうえで、実績と利用者数の多さは重要な判断材料となります。

Dify on AWS の導入をご検討中であれば、ぜひ今すぐ一歩を踏み出してみてください。Dify on AWS の導入や運用でお困りの際は、ぜひ Relipa へご相談ください。最適なソリューションをご提案します。

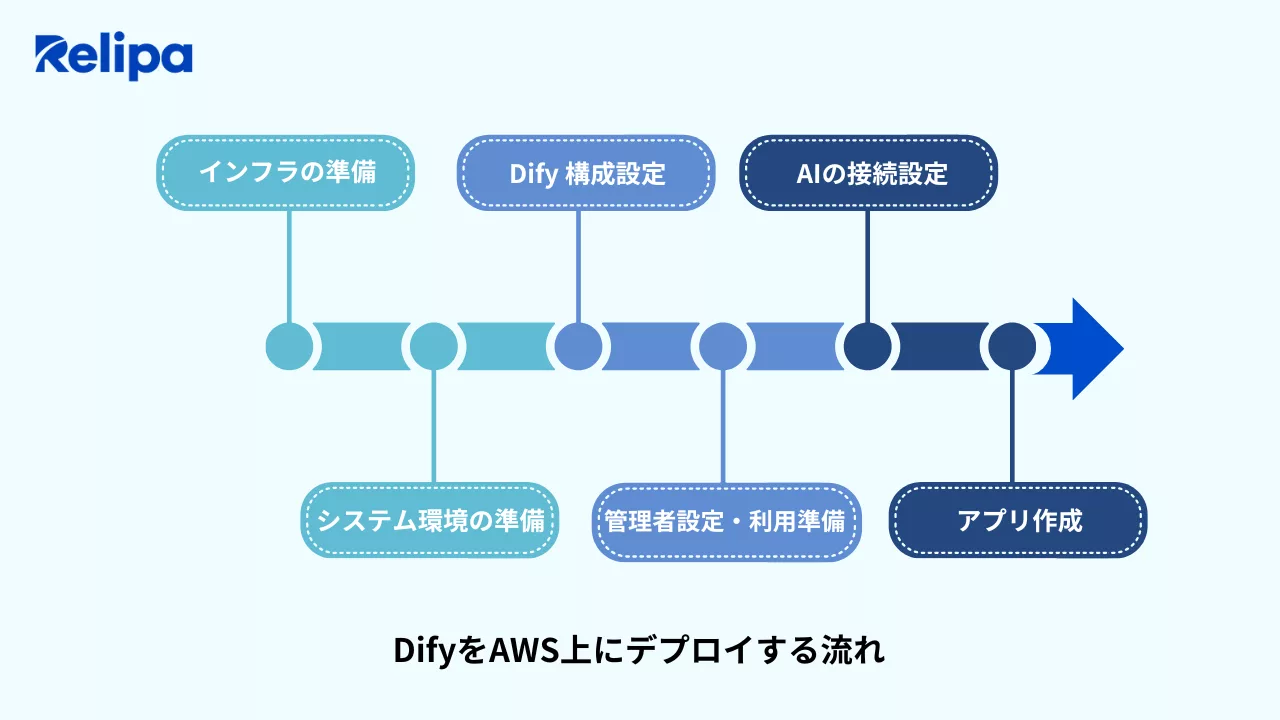

DifyをAWS上にデプロイする流れ

インフラの準備

Dify を導入するにあたり、まずは実行基盤となるインフラを整備します。AWS では、PoC や小規模利用であれば EC2、本番運用や将来的な拡張を見据える場合は ECS や EKS を選択するのが一般的です。

Ubuntu などの Linux 環境を用意し、VPC やセキュリティグループを設定することで、外部からのアクセスや通信範囲を適切に制御します。必要に応じて独自ドメインや SSL を設定することで、本番利用にも耐えうる環境を構築できます。

システム環境の準備

インフラが整ったら、次に Dify を安定して動作させるためのシステム環境を準備します。OS やパッケージを最新の状態に更新し、Docker や Docker Compose、Git などの基本ツールをインストールします。

これにより、Dify のコンテナ環境をスムーズに構築できるようになります。また、ストレージ容量や権限設定を事前に確認しておくことで、運用開始後のトラブルを防ぐことができます。

Dify のインストールと構成設定

システム環境の準備が完了したら、Dify 本体のインストールを行います。

公式リポジトリからソースコードを取得し、環境設定ファイルを作成してデータベースやキャッシュ、ストレージの接続情報を設定します。

その後、Docker Compose などを用いて Dify を起動し、API や管理画面が正しく動作しているかを確認します。この段階で、Dify の基本機能が利用可能な状態になります。

管理者設定と利用準備

Dify が起動した後は、管理者アカウントを作成し、ワークスペースやユーザー管理の設定を行います。管理者・開発者・一般ユーザーといった権限を分けることで、組織内で安全かつ効率的に利用できます。

また、利用制限やログ、監査設定を行うことで、企業利用に求められる運用管理体制を整えることができます。

AI(LLM)の接続設定

次に、Dify と生成 AIモデルを連携させます。OpenAI、Claude、Gemini などの API キーを登録し、用途に応じて使用するモデルやトークン上限を設定します。

Dify では複数の LLM を同時に管理できるため、コストや精度、用途に応じた使い分けが可能です。設定後はテストを行い、正しく応答が返ることを確認します。

AWS 上で運用する場合、Amazon Bedrock を利用することで、外部 API を使わずに生成AIを VPC 内で安全に利用できます。

AI アプリケーションの作成

最後に、実際の業務で利用する AI アプリケーションを作成します。

チャットボットやエージェント、ワークフローなどの形式を選択し、プロンプトや処理ロジックを設計します。社内データや外部 API と連携させることで、より実践的な業務自動化が実現できます。テストと改善を重ねた後、アプリを公開することで、Dify を業務に本格活用できるようになります。

Dify AWS 構築後の注意点

定期的なバックアップ

Dify を AWS 上で運用する場合、データベースや設定情報、ユーザーデータを定期的にバックアップすることが重要です。RDS や EBS、S3 などの AWS サービスを活用することで、自動バックアップや世代管理が可能になります。

万が一の障害や誤操作に備え、復元手順を含めたバックアップ体制を事前に整えておくことで、業務への影響を最小限に抑えられます。

計画的なアップデート

Dify は継続的に機能改善やセキュリティ更新が行われるため、アップデートを適切に管理することが求められます。本番環境に直接適用するのではなく、検証環境で事前に動作確認を行ったうえで段階的に反映することで、サービス停止や不具合のリスクを低減できます。

AWS 上であれば、環境を分けた運用やロールバックも比較的容易に実施できます。

定期的なセキュリティレビュー

生成AI基盤として Dify を利用する以上、セキュリティの継続的な見直しは欠かせません。

IAM の権限設定やネットワークルール、ログ取得状況を定期的に確認し、不必要なアクセスや設定漏れがないかを点検します。また、API キーやシークレット情報の管理状況を見直すことで、情報漏えいリスクを抑えることができます。AWS の監査・ログ機能を活用することで、より高いセキュリティ水準を維持できます。

DifyをAWSにデプロイする際のコスト目安

AWS が公開している構成例によると、Dify を AWS 上で本番運用し、Amazon Bedrock(Claude 3.5 Sonnet v2)を利用する場合、月額コストは約 141 USD が一つの目安とされています(2025 年 2 月時点)。

Dify を EC2 上で常時稼働させ、生成AIに Amazon Bedrock を利用する構成を想定していました。

内訳(概算)

出典:Amazon

利用条件の想定(AWS公式例)

- 利用ユーザー数:50 人

- 利用頻度:1 人あたり 1 日 10 回

- 1 回あたり:入力 1,000 トークン/出力 400 トークン

- 稼働日数:月 22 日(約 11,000 回/月)

上記の試算では、コストの大半を Amazon Bedrock のトークン利用料が占めています。

そのため、Bedrock を使用せず、外部 LLM API(OpenAI、Anthropic など)を利用する場合や、検証目的で LLM 連携を行わない場合には、AWS 側の費用は EC2・EBS などのインフラ費用のみとなり、月額数十 USD 程度まで大幅に抑えることが可能です。

なお、検証・学習・技術確認を目的とした短期間・小規模なデプロイのケースでは、実際の総コストが 1 USD 前後、あるいはそれ以下に収まることもあります。

展望

今後、生成AI活用は PoC を超えて本格運用へと進み、セキュリティや拡張性を重視する企業を中心に、Dify on AWS の採用はさらに拡大すると考えられます。

AWS のスケーラブルな基盤と Amazon Bedrock などの進化により、Dify on AWS はアプリ開発にとどまらず、企業向け LLMOps 基盤としての価値を高めていくでしょう。

また、AI ネイティブ開発やドメイン特化型 AI の普及を背景に、柔軟性と拡張性を兼ね備えた Dify on AWS は、今後も企業の生成AI基盤として継続的な成長が期待されます。

>>>関連記事:

まとめ

生成AIが企業の取り組みとして定着しつつある中で、重要なのは「AIを導入するか」ではなく、自社のフェーズに合った形で、いかに持続的に活用していくかという視点です。Difyは、その手軽さと柔軟性から多くの企業にとって有効な選択肢であり、利用が進むにつれてAWS上での運用を検討する流れは自然なものと言えるでしょう。

Dify AWSは、AI活用を次の段階へ進めるための現実的な選択肢です。適切に設計・運用することで、AIを業務に根付かせ、将来的な拡張にも対応できる基盤となります。

Relipaは、約10年にわたる先端技術分野での開発実績を基盤に、近年はAI・LLM・Difyを活用した業務自動化およびDX支援に注力しております。業務要件の整理や活用目的の明確化を起点に、Dify AWSを前提とした全体アーキテクチャの設計から、ワークフロー構築、AIチャットボットの実装、導入後の運用改善まで、AI活用を業務に定着させるためのプロセスを一貫して支援できる点がRelipaの強みです。

また、DifyをAWS上で運用する際に求められるアーキテクチャ設計、セキュリティ対策、スケーラビリティを考慮した構成についても、企業のフェーズに合わせた現実的なご提案が可能です。

Dify AWSの導入や活用についてお悩みの際は、ぜひRelipaにご相談ください。

貴社に最適なAI基盤の構築を、実践的な視点からサポートいたします。

EN

EN